Installer et utiliser un LLM en local

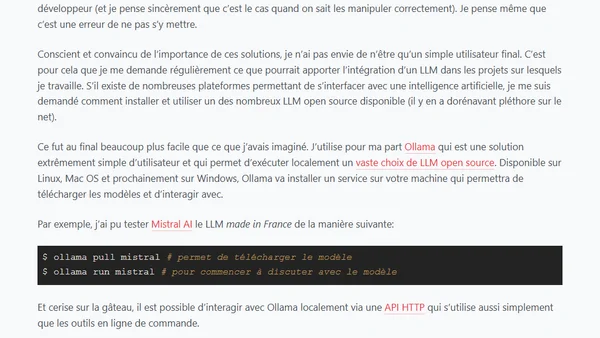

Read OriginalL'article explique comment installer et utiliser un modèle de langage (LLM) en local sur sa machine, en utilisant l'outil Ollama. Il détaille les étapes pour télécharger et exécuter un modèle comme Mistral AI, et mentionne la possibilité d'interagir via une API HTTP pour intégrer des LLM dans des projets de développement, avec un exemple concret en PHP.

0 comments

Comments

No comments yet

Be the first to share your thoughts!

Browser Extension

Get instant access to AllDevBlogs from your browser

Top of the Week

1

Quoting Thariq Shihipar

Simon Willison

•

2 votes

2

Using Browser Apis In React Practical Guide

Jivbcoop

•

2 votes

3

Better react-hook-form Smart Form Components

Maarten Hus

•

2 votes

4

Top picks — 2026 January

Paweł Grzybek

•

1 votes

5

In Praise of –dry-run

Henrik Warne

•

1 votes

6

Deep Learning is Powerful Because It Makes Hard Things Easy - Reflections 10 Years On

Ferenc Huszár

•

1 votes

7

Vibe coding your first iOS app

William Denniss

•

1 votes

8

AGI, ASI, A*I – Do we have all we need to get there?

John D. Cook

•

1 votes

9

Dew Drop – January 15, 2026 (#4583)

Alvin Ashcraft

•

1 votes