Installer et utiliser un LLM en local

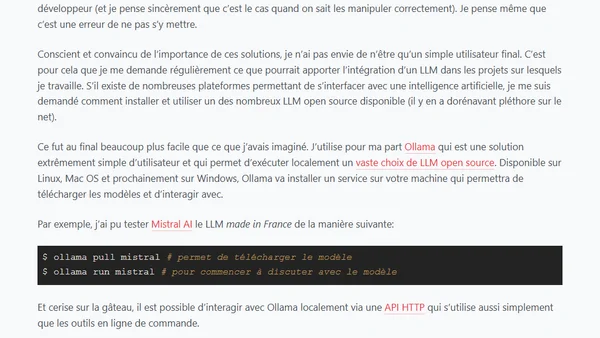

Read OriginalL'article explique comment installer et utiliser un modèle de langage (LLM) en local sur sa machine, en utilisant l'outil Ollama. Il détaille les étapes pour télécharger et exécuter un modèle comme Mistral AI, et mentionne la possibilité d'interagir via une API HTTP pour intégrer des LLM dans des projets de développement, avec un exemple concret en PHP.

0 commentaires

Commentaires

No comments yet

Be the first to share your thoughts!

Browser Extension

Get instant access to AllDevBlogs from your browser

Top of the Week

No top articles yet