#SemanticKernel: Local LLMs Unleashed on #RaspberryPi 5

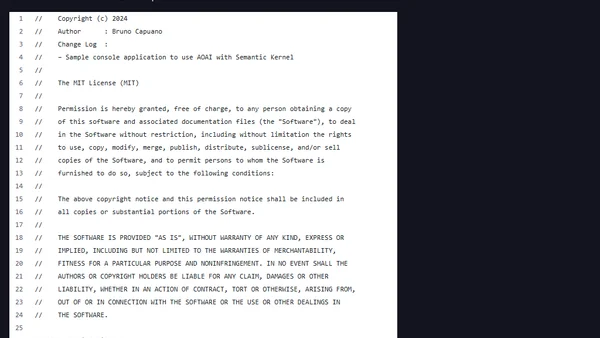

Przeczytaj oryginałThis article provides a technical guide on deploying local Large Language Models (LLMs) such as Llama3 and Phi-3 on a Raspberry Pi 5 using the Ollama platform. It covers the benefits of local LLMs, including enhanced privacy, reduced latency, and cost savings, and includes a step-by-step setup tutorial for installing and running models on the device.

0 komentarzy

komentarzy

Brak komentarzy

Bądź pierwszy, który podzieli się swoimi myślami!

Rozszerzenie przeglądarki

Uzyskaj natychmiastowy dostęp do AllDevBlogs z przeglądarki

Tydzień

No top articles yet